生成AI(Generative AI)は、データをもとに新しいデータを生成する人工知能の一分野です。

以下に生成AIの主要なポイントを説明します。

1. 定義と概要

生成AIは、入力データを基に新しいデータやコンテンツを生成する技術です。主にディープラーニングの技術を使用し、以下のような多様な生成タスクを行います:

- 画像生成(例:新しい写真や絵画の生成)

- テキスト生成(例:文章や詩の作成)

- 音声生成(例:音楽やナレーションの生成)

- 動画生成(例:新しいビデオクリップの作成)

2. 主なアルゴリズム

生成AIの主要なアルゴリズムには以下のようなものがあります:

- GAN(Generative Adversarial Networks):二つのニューラルネットワーク(生成者と識別者)が競い合うことで、高品質なデータを生成します。

- VAE(Variational Autoencoders):データの潜在表現を学習し、その潜在空間から新しいデータを生成します。

- Transformerモデル:特に自然言語処理で広く使われており、GPT(Generative Pre-trained Transformer)やBERT(Bidirectional Encoder Representations from Transformers)などが有名です。

3. 応用例

生成AIは多くの分野で活用されています:

- クリエイティブ分野:アート、音楽、文学などの新しい作品の生成。

- エンターテインメント:ゲームのキャラクターやシナリオの生成、映画の特殊効果。

- ビジネス:マーケティングコンテンツの生成、自動化されたレポート作成。

- 医療:新薬のデザインや、医療画像の生成と解析。

- 教育:学習教材の自動生成、インタラクティブな学習体験の提供。

4. 利点と課題

生成AIの利点には以下があります:

- 創造性の促進:新しいアイデアやコンテンツを生成し、人間の創造性を補完します。

- 効率化:自動化により、時間とコストの削減が可能です。

一方で、以下の課題も存在します:

- 倫理的問題:フェイクコンテンツの生成や著作権侵害のリスク。

- 品質のばらつき:生成されたコンテンツの品質が一貫しない場合があります。

- データ依存性:高品質な生成のためには、大量の高品質データが必要です。

生成AIは、技術的進歩とともにますます多様な分野での応用が期待されていますが、倫理的な配慮と技術的な改善が求められています。

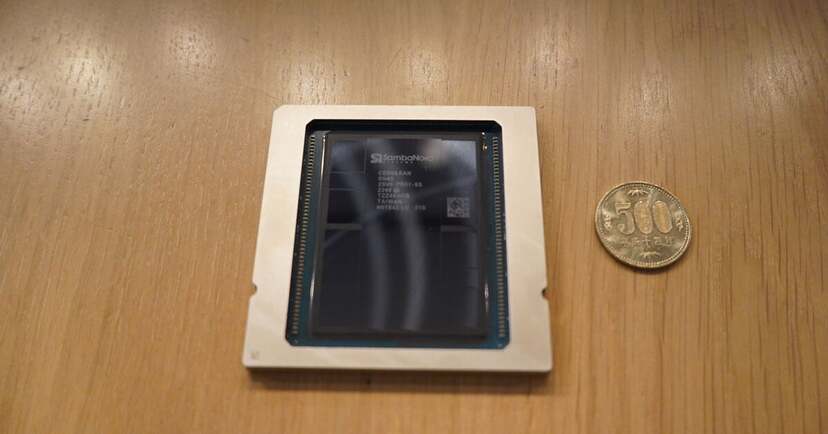

2017年に設立されたSambaNovaは、独自のAI半導体、ソフトウェア、システム、基盤モデルを統合したフルスタックAIプラットフォームを提供することで、オンプレミスで手軽な推論環境を構築できることを武器にカスタマを増やしてきた。日本でもソフトバンクが導入を決定したほか、日本語の大規模言語モデル(LLM)「Fugaku-LLM」が50種類以上の高品質オープンソース生成AIモデルで構成されたエンタープライズ向け1.3兆パラメータの生成AIモデル「Samba-1」のComposition of Experts(CoE)のエキスパートとして導入されるなど、実績を上げつつある(日本語LLMに関しては、東京工業大学のSwallowシリーズやELYZAのELYZA-japanese-llama-2-7bなども導入が進んでいる)。

同社Senior Vice President, Products(製品担当上級副社長)のMarshall Choy(マーシャル・チョイ)氏は、同社のフルスタックAIプラットフォームの特長について、「GPUのアーキテクチャについても検討したが、データの移動などに問題があった(GPUはCPUとやり取りしてメモリにアクセスする必要がある)。我々は専用のAI半導体であるRDU(Reconfigurable Dataflow Unit)を開発することで、この問題を解決することにした。最新世代となる第4世代品「SN40L」では、520MBのオンチップメモリ(SRAM)に加え、64GBのHBM3をキャッシュとして活用し、その先に外付けで1.5TBのDDR5 DRAMという3層データフローメモリ構成を採用することで、GPUに対しメモリフットプリントを20%ほど向上。専用コンパイラとの連携により、高いパフォーマンスと低いレイテンシを提供できるようになった」と、独自発想のAI半導体が源泉となっていることを強調する。

また、そのシステムとしてのコンパクトさも特長だとする。オンプレミス向けには19インチラックにx86 CPU×2に8個のSN40Lを搭載したユニット単位で提供される。今回提供が開始されたSambaNova Fast APIは、このSambaNova-1が提供する事前トレーニング済みモデルとチップ機能への手軽なアクセスを開発者たちに向けて提供することを目的としたもの。提供されるのは、Llama 3(8B)およびLlama-3(70B)のフル精度推論で、独自のチェックポイントを持ち込み、トークンベースで制限付きながら無料でAPIを活用し、超高速推論を体験することができ、契約後に専用URL、APIキー、およびドキュメントが提供され、SambaNovaの計算リソースを活用してモデルをファインチューニングすることも可能だという。

実際にAPIを利用するためには、専用Webサイトからユーザー登録を行う必要があるが、その前に、SN40Lを16基活用する「Samba-1 Turbo」を活用したデモを専用サイトで無料で体験することができる。

このSamba-1 Turboのデモサイトは、画面の右上にドロップダウンのメニューがあり、そこで利用可能なLLMが表示されるので、使いたいものを選び、画面下の入力欄にプロンプトを記入する形で実行できる。

日本語環境にも対応しているほか、デモ用のプロンプトも用意されており、それをクリックするだけで出力を見ることもできる。その処理速度は、実際にデモを体感してもらうと実感を持ってわかっていただけると思うが、デフォルト設定となっている「Meta-Llama-3-8B-Instruct」の場合、1秒当たりに生成できるトークン数が1000超と、爆速といえる速さ。あまりの速さに出力の最初の方はページ外にスクロールしていってしまう。

また、その拡張機能の1つとして、「プロンプトの入力エリア」の左となりに用意された「Real-Time」のチェックボタンがある。これをオンにすると、プロンプトを入力中であっても、生成AIが出力を随時実行。プロンプトの変更に応じて、リアルタイムで書き換えていく様子を見ることができる。チョイ氏は「開発者やスタートアップにAPIを公開することにしたのは、すぐに大きな投資に踏み切るのではなく、まずは使ってもらう、という意味合いが大きい。エコシステムの中にいることが重要で、中にいるからこそ、我々のモデルを使ってソリューションを組んでもらうといった連携もできる。そうした意味では、今回の取り組みはデベロッパーを重視したものとなる」とこの取り組みの意義を説明する。

なぜ、こうした取り組みを推進するのか。同氏は「エージェンティックAI時代、つまりこれまでの人間とAIの関係を超えて、エージェントとエージェント、エージェントとシステムが連携しあう時代が到来しようとしており、それはビジネスシーンでの活用が進むことを意味する。そうした中で、具体的に、いかに少ないハードウェアリソースで多くの言語モデルをサポートして、性能要件を低コストかつ低レイテンシで実現するのか、消費電力の削減も併せて、SambaNovaがサポートできると信じている」と自社の指向するRDUの活用が、これから来るであろう新たな生成AIを活用する時代の最適解になると強調。推論環境でありながら、量子化をせずにフル精度で高速化を実現している点も、高い精度を提供する必要があるビジネスシーンで必要とされる要素とし、Fast APIがそうした時代の最適なプラットフォームの第一歩となるとした。

(小林行雄)